KI-Betrug

Achtung, Betrugsmasche: KI faked jetzt die Stimme deiner Mutter

Stand 13.07.23 - 13:48 Uhr

Täuschend echt! KI wird in vielen verschiedenen Bereichen angewendet. Doch nun wird die KI für kriminelle Zwecke missbraucht. Wie funktioniert die Masche?

©shutterstock

Digitalisierter Betrug: KI klont Stimmen

Ob Enkel-Trick, Schockanrufe oder Erpressung – immer mehr Kriminelle nutzen neue Methoden, um Smartphone Nutzer zu täuschen und ihnen Geld abzukassieren. Bei den Anrufen handelt es sich um ein zielgruppengerechtes Ködern durch authentische Stimmen. Hier erfährst du mehr zu den verschiedenen Szenarien und worauf du achten solltest.

- Anzeige -KI-Phishing-Anrufmasche

Auf die Phishing SMS fallen nicht mehr viele Menschen rein. Bei einem Anruf, der echt klingt, werden es vermutlich mehr sein. Spätestens nach der neuen Pumuckl-Serie wird gezeigt, wie leicht es ist, eine generierte Stimme echt klingen zu lassen.

Wie sich nun aber herausstellt, nutzen Kriminelle die Technologie in der Praxis, um ihre Erpressungsmethoden zu erweitern. Dabei klonen sie Stimmen, um angebliche Verwandte darzustellen.

Doch wie funktioniert das Klonen?

Die KI nutzt dafür kurze O-Töne aus einer Sprachnachricht, YouTube oder den sozialen Medien. Alle Stimmen, die im Internet landen, können geklont werden.

Bestimmte Programme sammeln das Tonmaterial und erstellen eine geklonte Version mit einem eigenen Text. Erschreckend ist, dass nur drei Sekunden Material reicht, um eine generierte Nachricht zu erstellen.

Das KI-Programm schafft es, die Tonlage, Emotionen und Aussprache der Stimme sehr genau zu imitieren.

- Anzeige -Hallo Mama, ich bin’s – KI kann auch deine Stimme nachstellen!

Beim Enkel-Trick sind insbesondere ältere Menschen betroffen. Doch auch jüngere Menschen können auf die authentischen Anrufe hereinfallen. Vorwiegend, wenn die Stimme wie die von der Mama, dem Papa, der Tochter oder dem Sohn klingt.

Ein anderes Beispiel ist, wenn es ein Problem mit dem Online-Banking gibt und eine Überweisung dringend durchgeführt werden muss.

Eine KI-sprachgenerierte Stimme ruft auf dem Smartphone an und gibt vor, eine verwandte Person zu sein, dabei ist die Stimme nicht von der echten Person zu unterscheiden.

In solchen Situationen werden die Personen am Telefon unter Druck gesetzt und um Geld gebeten, um der anderen Person aus einer vermeintlichen Notlage zu helfen.

Bisher sind ein paar Vorfälle aus den USA bekannt, aber auch bei uns in Deutschland warnen Cyber-Experten und das Bundeskriminalamt vor der Betrugsmasche und meinen, dass in Zukunft die Zahl der gefakten Anrufe mittels KI-Stimme zunehmen werden.

Wie kannst du dich schützen?

- Anzahlungen von über 30 Prozent der Kosten unbedingt vermeiden.

- Ausgiebige Recherche (beispielsweise über Google Street View, um zu sehen, ob sich der vermeintliche Ort tatsächlich in dieser Straße befindet).

- Bei Verdacht während des Telefonats eine dumme Frage stellen und auf die Reaktion der anderen Person warten (meist handelt es sich bei den Anrufen um fixe Gesprächsabläufe, Gegenfragen, können noch nicht beantwortet werden).

- Nicht unter Druck setzen lassen, sondern einen Rückruf über das Festnetztelefon durchführen oder im besten Falle ein persönliches Gespräch suchen.

Bleib immer bestens informiert!

Mit unserem kostenlosen 95.5 Charivari-Newsletter verpasst du keine Highlights mehr. Von Top-Konzerten über exklusive Gewinnspiele bis hin zu Einblicken in Larissa Lannert live - wir liefern dir wöchentlich alles Wichtige direkt in dein Postfach.

Mehr Beiträge und Themen

Tempo 50 oder Tempo 30 auf der Landshuter Allee? Jetzt gab es ein neues Urteil am Münchner Verwaltungsgericht.

Am Faschingsdienstag wird es besonders bunt im Tierpark: verkleidete Kinder bis 14 Jahre kommen kostenlos in den Tierpark Hellabrunn.

Am Handy mit einem Klick die Steuererklärung machen? Was lange wie ein unerfüllbarer Wunsch klang, soll ab Juli möglich werden. Zumindest für die ersten Nutzerinnen und Nutzer in Deutschland.

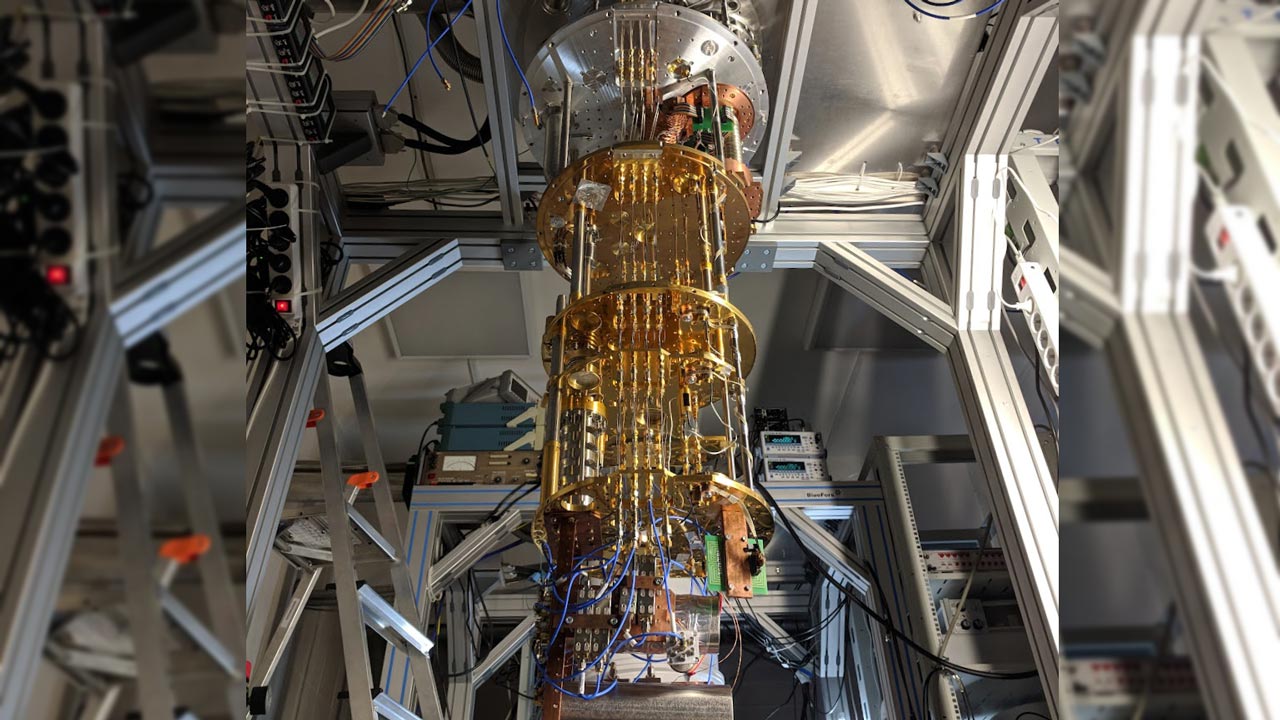

Wie ein Kühlschrank auf minus 273 Grad für Hoffnung auf staufreie Städte und schnellere Medikamentenforschung sorgt. Und warum Bankdaten trotzdem noch sicher sind.

Am 14. Februar, werden zu einer Kundgebung gegen das iranische Regime bis zu 100.000 Teilnehmer:innen erwartet. Wird diese Zahl erfüllt, handelt es sich um die drittgrößte Demonstration der Münchner Stadtgeschichte.

Rund um den Bayerischen Hof in der Innenstadt gelten an diesem Wochenende umfangreiche Sicherheitsmaßnahmen, dazu kommen Verkehrseinschränkungen, Umleitungen im Nahverkehr und mehrere Großdemonstrationen.

Mitte Juni startet das beliebte Sommer Tollwood 2026 - neben tollen Musik-Acts gibt es wie immer viel zu entdecken.

Wer darf wählen, wer kann kandidieren und wie funktioniert die Stimmabgabe – auch per Briefwahl? Hier findest du die wichtigsten Informationen im Überblick.

Rückruf bei BMW: Brandgefahr durch fehlerhafte Starter. Erfahre, welche Modelle betroffen sind und wie du prüfen kannst, ob dein Auto dazugehört.

In mehreren Wohngebieten in Unterschleißheim sind Vermietungen über Plattformen wie Airbnb oder die Nutzung als Ferienwohnung künftig verboten. Ziel der Maßnahme: den angespannten Wohnungsmarkt entlasten und Leerstand verhindern.

DESK

„All good things come to an end.“ Nach fast zehn Jahren muss der Blitz Music Club nun seine Türen schließen.

Die Debatte über Social-Media-Verbote für Kids läuft auf Hochtouren. Allen voran schaltet sich der Kanzler ein. Doch kann ein Verbot alleine ausreichen?

Hunderttausende Pendler müssen in München kommende Woche schon wieder nach Alternativen zum ÖPNV suchen.

Es geht wieder los: die Starkbierfeste in München. Wir zeigen dir, wo sie stattfinden und wann du dabei sein kannst.

Im Urwaldhaus klammert sich das Schimpansenbaby an Mama Zenta und wirft erste neugierige Blicke – ein niedlicher Anblick für Gäste im Münchner Tierpark Hellabrunn.

Ein Gericht ordnet an, dass an der Landshuter Allee in München langsamer gefahren werden muss. Trotzdem will der Oberbürgermeister erst mal nichts ändern. Jetzt erhöht die Gegenseite den Druck.

Hast du schon mal was richtig Cooles bei einer Versteigerung ergattert? Am 25. Februar 2026 hast du wieder die Chance! Die MVG versteigert jede Menge Fundsachen, die in U-Bahn, Tram und Bus liegengeblieben sind.